שלום כולם, וברוכים הבאים לאלישע והזוויות, עונה שניה פרק מספר שבע! היום ה-9 בדצמבר, 2024, ואנחנו נדבר היום על כל מני דברים, כולל מודלים שמאבדים את שפיותם! אז יהיה מעניין!

חוץ מזה, הרבה זמן כבר שאני שוכח להדגיש, למי שמעוניין, את קיומו של אתר אינטרנט לפודקאסט: הלינק נמצא בתיאור הפרק בספוטיפיי או ביוטוב, ומי שנרשם לאתר מקבל מייל כשיוצא פרק חדש, וגם יכול לקרוא את התמלול של הפרק. במיוחד בעונה הזו, התמונות והייצוגים הויזואליים מאד עוזרים, אז יש אתר כזה, ובואו תירשמו!

בואו נפתח את הפרק שלנו היום בשאלה, כדי לעורר את התיאבון: מה היה קורה אם היינו מאמנים את GPT על הפלט של GPT עצמו?

כדי לוודא שכולנו מיישרים קו, בואו ואפרק את השאלה הזו לגורמים שלה, על פי כל הדברים שראינו בעונה עד כה. נתחיל בתזכורת על איך הכלי הזה שקוראים לו GPT נוצר. GPT זו בעצם מערכת AI ש"האכילו" אותה המון קטעי טקסט שכתבו בני אדם, היא חילצה את התבניות שחבויות בהם בתהליך אינדוקטיבי, באופן כזה שהיא יכולה להפעיל את התבניות בתהליך דדוקטיבי ולייצר טקסטים חדשים. לתהליך האינדוקציה נקרא "אימון" או "למידה", בעוד שלתהליך הדדוקציה נקרא “הפעלה” של המודל המאומן. ושווה לזכור - המודל הזה מתחיל טאבולה ראסה, נקי מכל מידע על שפה, ורק תהליך החשיפה לדאטה אנושי מעצב אותו, כמו פלסטלינה, כך שהטקסטים שהוא מייצר יהיו דומים לטקסטים שהוא אומן עליהם, כלומר טקסטים אנושיים.

ובכן, נחזור עכשיו לשאלה שבה פתחתי. נניח שיש לי מודל שפה משלי בשם ג'פטו, שהוא בעצם GPT של היום. אז עכשיו אני יכול לבקש ממנו לייצר לי המון טקסטים בהמון נושאים, ואז לקחת אותם, ולהשתמש בהם כדי לאמן GPT חדש. אנחנו נקרא לו פינוקיו, שהרי בעצם ג'פטו כאן הוא זה שמאמן את פינוקיו, ובכך נופח בו חיים. ואז השאלה היא - באיזו איכות יהיו הטקסטים של פינוקיו? או במילים אחרות - האם פינוקיו יהיה ילד אמיתי, או רק בובה על חוטים?

השאלה הזו תלווה אותנו לאורך הפרק היום, אבל עוד לפני זה היא מתקשרת לפרק שעבר. כפי שאתם זוכרים, דיברנו שם באופן נרחב על הקשיים שיש בהשגת דאטה שבני אדם ייצרו לצורך אימון של מודלים. כיוון שכך, החלום הרטוב של עולם ה-AI הוא שלא נזדקק לבני אדם במשימה הזו בהיקפים גדלים והולכים, וזאת משום שנוכל פשוט לבקש מה-AI של הדור הקודם לייצר לנו דאטה שכזה. אם ג'פטו יכול לייצר דאטה באיכות גבוהה דייה, כך שפינוקיו יהיה ילד ככל הילדים, אז גם אם יגמר כל הדאטה הזמין באינטרנט אפשר יהיה לייצר עוד דאטה סינתטי בקלות רבה, בלחיצת כפתור.

בשל החשיבות הרבה של הנושא הזה, נעשו ניסויים מדעיים בעניין, ואני אסקור כמה מהם בהמשך הפרק. בינתיים, קחו אולי איזו דקה לחשוב מה קרה באותם ניסויים. האם התברר שפינוקיו הוא מודל שקול בעוצמתו לג'פטו? אולי הוא אפילו היה חזק ומדוייק יותר ביכולותיו? או שמא להיפך, הביצועים שלו התדרדרו והתכנסו למשהו בינוני? התשובות - בהמשך.

בפרק שלנו היום אני רוצה להמשיך את מה שהתחלנו בפרק הקודם, ולטעון שההישענות על דאטה אנושי הינה עקב האכילס של מודלי ה-AI העדכניים. זה כמובן די מצחיק לחשוב שאני שוקל להציג טיעון שכזה, שכן ההישענות הזו היא גם פריצת הדרך שאיפשרה, בעשור האחרון, למהפכת ה-AI המדהימה שסביבנו. אבל תזכרו את מה שראינו בשבוע שעבר: שבדאטה שבני אדם מייצרים יש בהחלט המון מידע שיכול לעזור לנו לבנות כלי AI חזקים, אבל יש מקום להטיל ספק בשאלה אם זה מספיק כדי להגיע לבינה מלאכותית שהיא באמת תבונית. כלומר, הטיעון שלי יהיה שאנו צריכים עוד מהפכות משמעותיות ב-AI לפני שנוכל להגיע לבינה מלאכותית אמיתית, וכל עוד אנחנו מתעקשים להישען בעיקר על אימון מתוך דאטה, אנחנו מפספסים משהו גדול מאד בסיפור.

כדי להדגים את זה, אני רוצה שנתחיל את המסע שלנו בניתוח מדוקדק יותר של מבחן טיורינג. כפי שאתם זוכרים, במבחן טיורינג יושב לו אדם - נניח, אישה - ומקבלת את תפקיד הבוחנת. היא מנהלת שיחה עם דמות כלשהי דרך צ'ט, ולאחר כמה דקות של שיחה מודיעה אם לדעתה מדובר במחשב או אדם. בחינה מדוקדקת של המבחן הזה תגלה משהו חשוב, שכבר רמזנו עליו בפרק השני של העונה: הגורם האנושי שבבדיקה הזו איננה חלק מהותי מהמבחן, אלא פשוט המדד הכי זמין לתבונה שיש בידינו. טיורינג השתמש במדד הזה של "האם המכונה הצליחה להתל בבוחנת" פשוט בשל הזמינות של המדד והאינטואטיביות שלו. המהות של מבחן טיורינג, לעומת זאת, זו הקביעה הבאה: שאם מכונה מפיקה פלט באיכות ששקולה לזה של פלט אנושי - אזי היישות הזו תיחשב תבונית.

שווה להדגיש את החלק הראשון - שבדיקה אנושית של איכות הטקסט איננה המרכיב המהותי במבחן טיורינג - כיוון שבניסויים שנעשו מתברר שיש כל מני בעיות בלסמוך על עצמנו. איך לומר זאת בעדינות - אנחנו לא כאלה טובים בלזהות תבונה אנושית כמו שאנחנו חושבים. קחו לדוגמה את התוצאות של מאמר שיצא לפני כשנה, שבו ניסו כמה חוקרים לבדוק עד כמהGPT גרסה 4 מצליח לעבור את מבחן טיורינג. בניסוי הכי מוצלח שלהם, הצליח GPT לשכנע 50% מאלו שדיברו איתו דרך צ'ט שהוא בעצם בן-אדם, שזו באמת הצלחה מרשימה ביותר (מערכות ישנות יותר שפותחו בשנות ה-60 של המאה הקודמת, כמו ELIZA, הגיעו להצלחה של 22% בלבד). אבל באותו מאמר גם הופיע פרט אחר, חשוב לא פחות, שקשור לתמונת המראה לתוצאה הזו: באותו ניסוי, כאשר מן העבר השני של הצ'אט היו בני אדם ולא מכונה, הבוחנים זיהו שמדובר בבני אדם רק ב-66% מהפעמים. במילים אחרות, בשליש מהפעמים שהם דיברו עם בני אדם, חשבו הבוחנים האנושיים שמדובר דווקא במכונה! אז נכון, בני האדם היו משכנעים יותר מה-50% של GPT, אבל התוצאה הזו כשלעצמה מטילה צל כבד על הקונספט הבסיסי של מבחן טיורינג: שבני אדם יודעים לזהות חשיבה אנושית דרך צ'ט אינטרנטי.

מדובר, כמובן, רק במאמר אחד, ואפשר לצלול לפרטיו ולאתגר אותו וכן הלאה. אבל הוא כן ממחיש שהמסנן האנושי איננו בהכרח מדוייק. ולכן, אפשר לשדרג את מבחן טיורינג אם נמצא דרכים אחרות לבחון את הפלט הזה, דרכים שאינם עוברות דרך הערכה אנושית סובייקטיבית. כך אולי נוכל לדייק יותר את ההערכות שלנו לגביי תבוניות המכונה. אבל - האם יש דרכים כאלו?

התשובה היא כמובן שכן, יש כל מני דרכים אלטרנטיביות לבדוק את זה, ואת חלקן אנחנו גם נפגוש בפרקים עתידיים, אם הכל יצא לפי התכנית. היום ספיצפית אנחנו נלך על משהו קצת יותר מגניב, שכמו האקדח של צ'כוב כבר ראיתם במערכה הראשונה: הניסוי הזה עם ג'פטו ופינוקיו! שימו לב:

ג'פטו אומן על דאטה אנושי - זה נתון.

פינוקיו מאומן על דאטה שג'פטו יצר. גם זה נתון.

אז אם הפלט של ג'פטו הוא פלט ששקול לפלט אנושי - כלומר, אם ג'פטו עומד בדרישות מבחן טיורינג - פינוקיו אמור להיות שקול לג'פטו. כלומר, אם ג'פטו הצליח להטמיע אצלו בינה ששקולה לבינה אנושית, אז הביצועים של יציר כפיו, של פינוקיו, לא אמורים ליפול מאלו שלו עצמו. מש”ל.

אולי זה היה קצת קשה לעקוב, אז בואו תנו לי רגע להציג את העניין מזווית אחרת, עם דימו ויזואלי שבטח יהיה אינטואטיבי יותר לרובכם. נניח שיש לכם תמונה שצייר חבר שלכם, ומכונת צילום. אתם לוקחים את התמונה, מצלמים עותק שלה במכונה, ואז משווים בין התמונה המקורית לבין התמונה המצולמת. אם מכונת הצילום מושלמת, לא אמור להיות הבדל בין שתי התמונות. ואם יש הבדל בין שתי התמונות, זה אומר שמשהו בפעולה של מכונת הצילום אינו מדוייק.

זה המשל. הנמשל הוא שמכונת הצילום היא ה-AI שלנו, תמונת המקור היא דאטה האימון האנושי, והצילום שיוצא מהמכונה הוא הדאטה הסינתטי שה-AI מייצר בעצמו. עכשיו, אם יש לנו AI שתפס באופן מושלם את מהות השפה והשיח האנושיים, אז לא אמור להיות הבדל בין שני סוגי הדאטה. ולעומת זאת, אם יש הבדל ניכר בין התמונה המקורית לצילום, הרי שזה אומר שמשהו ב-AI שלנו איננו מדוייק; מכונת הצילום המתוחכמת שבנינו כנראה מכילה שריטות על הזכוכית שלה, שמעוותים את התוצרים שלה.

זהו המבחן שאני מציע לשדרוג מבחן טיורינג - בואו נקרא לו כאן "מבחן הזוויות". וכיוון שעכשיו הוא יושב לנו טוב בראש, שווה לשאול - מה קורה שמפעילים אותו?

ובכן, אני שמח לבשר לכם שאני לא היחיד שחשב עליו, ויש כמה מאמרים שיצאו בנושא. ב-2023, עמוק בתוך ההתלהבות מכל ה-GPT למיניהם, ישבו כמה חוקרים מאוניברסיטת רייס (RICE) שבטקסס, ועשו ניסוי דומה למה שתיארתי. הם לקחו מודלים מוכרים לייצור תמונות של פרצופים, וייצרו איתם הרבה תמונות של פרצופים. עם התמונות הללו הם אימנו מודל חדש, וייצרו איתו תמונות של פרצופים גם כן. וכך הלאה, דור אחרי דור של מודלים, כל דור מבוסס על תוצרי הדור הקודם. כלומר, הם בעצם עשו את "ניסוי ג'פטו ופינוקיו" שלנו שוב ושוב, בשרשרת, ובסוף התהליך הם בדקו מה האיכות של התמונות שכל דור ייצר.

לקראת הניסוי, אני מדמיין לעצמי מה חשבו החוקרים שהם יקבלו. הגירסה האופטימית היתה כנראה שהתמונות בכל דור יהיו טובות כמו הדורות שקדמו להם. הגירסה הפסימית יותר היתה שהתמונות החדשות יפלו באיכותן, בגלל חוסרים כלשהם במודל, אבל יתייצבו על רמה סבירה כלשהי. ובכן, מה אתם חושבים שקרה?

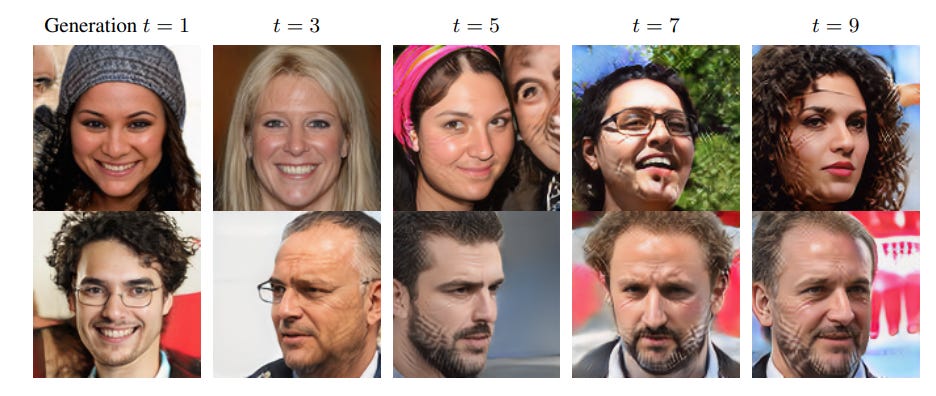

מה שקרה היה משהו אחר לחלוטין - גרסה פסימית על סטרואידים. בכל סבב שכזה, הביצועים של המודל הלכו והתדרדרו. התמונות שנוצרו לאחר כמה דורות הכילו עיוותים, פסים מוזרים שהחלו להופיע על הפרצופים שהמודל יצר:

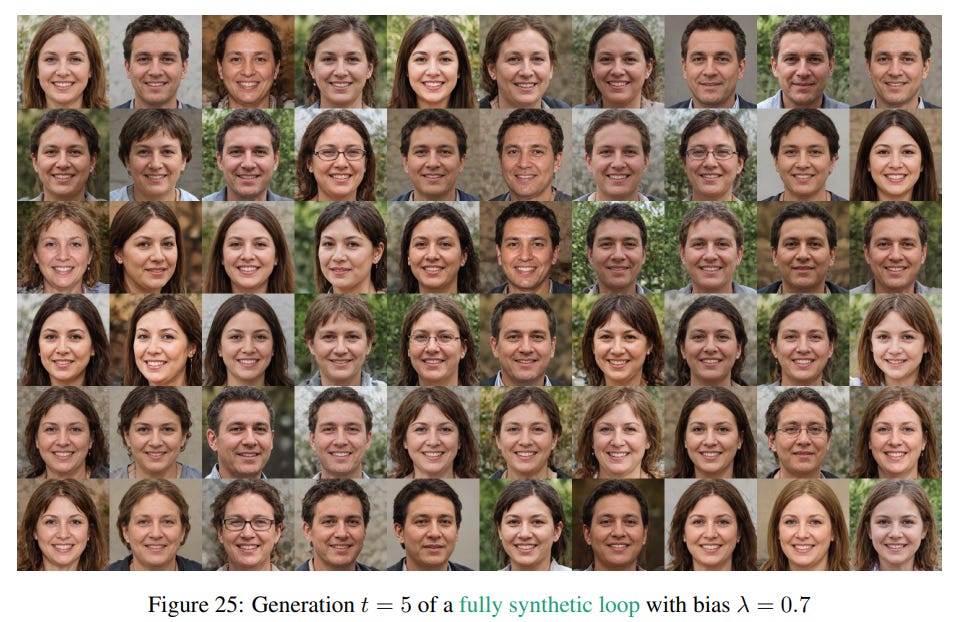

בגרסאות שונות של הניסוי המגוון האנושי שהמודלים יצרו בכל דור חדש הלך והצטמצם, והתכנס לאוסף תמונות שנראות מאד דומות זו לזו - תמונות של גברים ונשים לבנים עם שער כהה ועיניים מערביות, שמביטים ישר למצלמה ומחייכים. שימו לב כאן לאוסף התמונות שהיה בהתחלה…

… לעומת אלו שנוצרו לאחר כמה דורות:

בכל אופן, לתופעה הזו קראו כותבי המאמר, model autophagy disorder, ראשי תיבות MAD, כלומר אי-שפיות. בכך הם ניסו לומר - כשמתמידים בתהליך הזה לאורך זמן, המודלים מתנהגים כאילו הם מאבדים את שפיותם. בהקשרים אחרים יש שקראו לתופעה הזו Hapsburg AI, בהתייחסות לשושלת האפסברג האוסטרית, שמרוב זה שהם התחתנו כל הזמן בתוך המשפחה הם דיללו את היציבות הגנטית שלהם, פיתחו כל מני מוטציות מוזרות ואולי הדבר אף גרם להכחדת השושלת.

שווה לשים לב במיוחד לעובדה שביצועי המודלים בניסוי נהיו גרועים יותר מדור אחד לשני. אם נניח היינו רואים שיש ירידה מג'פטו המקורי לפינוקיו בכמה אחוזים, אבל משם הדברים מתייצבים ושומרים על רמת איכות נתונה מדור אחד לדור הבא, זה היה סיפור אחר. במצב שכזה היינו אומרים - “אוקיי, הצלחנו לתפוס 80% מהיעד באופן מדוייק”. בפועל מה שהניסוי הזה המחיש הוא שה-AI לא באמת יודע להבחין בין עיקר לטפל ולסנן טעויות שהוא נחשף אליהם, ולכן כל דור של אימון רק מעצים את העיוותים שהוא ראה בדאטה של הדור הקודם. אם נחזור שוב למשל מכונת הצילום שלנו, נראה לי שברור לכולנו שיש הבדל בין מקרה שבו מכונת הצילום פשוט לא עובדת טוב עם דפים מקומטים, לבין מצב שבו יש שריטה על הזכוכית של מכונת הצילום עצמה. במקרה הראשון מדובר בבעיה מקומית ומוגבלת למקרים נדירים, שלא תפריע לרוב, בעוד במקרה השני זו בעיה שתשליך על כל הצילומים כולם, בלי יוצא מן הכלל. וזה מאד מטריד.

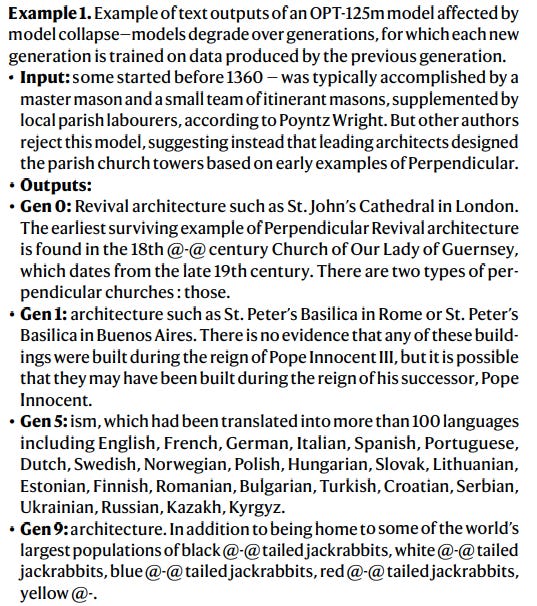

לצד המאמר הזה, יצא גם מאמר נוסף ביולי השנה שבחן את הנושא במודלים חדשים יותר, ושהכותרת שלו אומרת הכל: "AI models collapse when trained on recursively generated data". "מודלי AI קורסים כאשר הם מאומנים על דאטה שמיוצר רקורסיבית". אצלם הם הריצו את הניסוי גם על מודלים שמייצרים טקסטים, וגם שם התגלה שהטקסטים נהיים גרועים יותר ויותר ככל שהדורות מתקדמים. וגם כאן, ההתדרדרות הגיעה בשתי תצורות: לטקסטים יבשים מצד אחד, שזה מזכיר את הפרצופים האחידים מהמאמר הקודם, וטקסטים משובשים בטירוף מצד שני. בתמונה שתראו כאן, נתנו למכונה תחילת משפט וביקשו שהיא תשלים אותו - שימו לב איך כל דור (Gen0, Gen1…) מציג התדרדרות באיכות ההשלמה, עד שזה בסוף מגיע לג’יבריש מוחלט.

באותו מאמר, בנוסף לניסויים שהם הריצו, הם גם פיתחו באופן מסודר את התיאוריה האנאליטית שמסבירה למה זה קורה באופן עקבי במודלים הללו, ולמה למודלים שבנויים על למידה מתוך דאטה בלבד אין באמת דרך להימלט מן הגורל הזה. כדי להבין את מה שהם מביאים שם במאמר, אנחנו צריכים לקחת שתי דקות כדי להסביר משהו חשוב על האופן שבו המודלים הללו מייצרים טקסטים מגוונים, כשהכל עובד כמו שצריך. אז, שימו לרגע בצד את ניסוי ג'פטו ופינוקיו שלנו ופתחו סוגריים בראש - אני מבטיח שהם לא יהיו ארוכים במיוחד.

כשמישהו שואל אתכם "מה נשמע", אתם יכולים לענות בהמון צורות. "טוב, תודה". "ברוך השם סבבה". "עייפים אך מרוצים", וכן הלאה. אחד הדברים המגניבים במודלים הללו הוא שגם הם, כמו בני אדם, לא עונים תמיד את אותו הדבר כשמשוחחים איתם. איך זה קורה, אתם בוודאי תוהים? מאין מגיע הגיוון הזה? נכון, הטקסטים שהם רואים בזמן האימון מכילים את המגוון הזה, אבל איך הם בוחרים מה לומר?

ובכן, למודלים הללו יש מידע סטטיסטי על תבניות השפה שלנו, ויודעים לומר איזו תגובה היא שכיחה ומקובלת, ואיזו נדירה ויוצאת דופן. כדי לייצר שיח טבעי, המודלים הללו בוחרים תבניות באופן אקראי, ומשתמשים בסטטיסטיקה על השפה כדי לבחור אופציה סבירה מבחינת ההקשר של השיחה. אז, אם נדמיין עקומת פעמון של התגובות המקובלות ל"מה נשמע", רוב הפעמים המודל יגיב באופן שנמצא במרכז הכובד של העקומה, ורק במקרים מאד נדירים הוא ישוטט לו בקצוות העקומה, ויתן פתאום תגובה לא צפוייה ממש ומפתיעה. האמת, שווה לציין כאן שלרוב המודלים הללו יש פרמטר מיוחד ששולט בהתנהגות הזו. קוראים לו בשם "טמפרטורה". כמו שאטומים זזים מהר יותר ורחוק יותר כשמגדילים את הטמפרטורה סביבם, כך גם המודל נע באופן קיצוני יותר כאשר מגבירים את הטמפרטורה שלו. במילים אחרות, ככל שמגדילים את אותה "טמפרטורה", אנחנו בעצם מעודדים אותו לשוטט באזורים הנדירים יותר של העקומה ולהגיב בצורה מפתיעה יותר, בעוד שככל שמנמיכים את פרמטר הטמפרטורה המודל יצמד למוכר, במרכז עקומת הפעמון.

אז, אלו הסוגריים, אתם יכולים לסגור אותם עכשיו, ואנחנו חוזרים לאותו מאמר. מה שכותבי המאמר הסבירו שם באופן אלגנטי היה שכשאנו מבקשים מג'פטו לייצר לנו דאטה לאימון של פינוקיו, אנחנו מוצאים את עצמנו תקועים בין הפטיש לסדן בכל הקשור לכיוון השיטוט שלו בעקומת הפעמון שלנו. נניח שאנחנו רוצים לבקש ממחולל התמונות שלנו שייצר לנו תמונות מייצגות של פרצופים, ואנחנו יודעים שלרוב האנשים בעולם אין צלקות על הפנים. אז אם נאמץ מדיניות שהולכת על בטוח, ונצמדת למרכז העקומה, נקבל אחלה תמונות, אבל נגרום לכך שבאימון של פינוקיו לא יהיו בכלל פרצופים עם צלקות. זהו הפטיש: אם אנחנו ניצמדים למה שמוכר ושכיח, אנחנו מתחילים לאבד את קצוות הפעמון, ובעצם למחוק ייצוגים של המציאות שמופיעים רק לעיתים רחוקות.

אולי תגידו - טוב, אז תדגום את הקצוות גם. נשמע סביר האמת. אלא שכאן מגיע הסדן. קצוות העקומה הם גם המקומות שבהם יש לנו פחות דאטה, ובאופן ניכר - הרי זה מה שהופך אותם לאירועים נדירים. באזורים הללו, המודל צריך למלא הרבה חורים, לנסות לנחש איך למקם את הדאטה הזה בהקשר הרחב יותר של העולם הפנימי שהוא בונה. דוגמה יחסית קלילה יכולה להיות שכנראה שיש גם פרצופים באינטרנט של אנשים שצבעו את פניהם לקראת משחק כדורגל בצבע ירוק. האם המודל צריך להסיק שיש אנשים עם פרצופים ירוקים בעולם, ולתת לזה ייצוג כמו לאנשים ממוצא אתני מסויים כשהוא מייצר פרצופים על פי בקשת המשתמש?

וזו דוגמה קלילה, כמו שאמרתי. האזורים הנדירים באמת הם האזורים שכמעט אין לנו שום דבר שם, ואם נייצר תמונות מהקצוות הרחוקים וניתן אותן בזמן האימון של פינוקיו, אנחנו בעצם מכניסים לו רעש. לפינוקיו אין שום דרך לדעת שאסור לו להסתמך עליהם - הרי זה דאטה כמו כל דאטה, ANYTHING GOES.

כדי להדגים את זה, לקראת הפרק ביקשתי ממערכות שכאלו לצייר את הציור הבא: "חתול שותה שמנת בקשית תוך כדי רכיבה על אופנוע הארלי-דייוידסון על ראש הר האוורסט, כשהוא חושב על פוליטיקה ומגרד לעצמו באוזן". שילוב שכזה הוא שילוב נדיר, וגם לא ברור איך יש לצייר אותו. והנה, זו הצורה שבה GROK של אילון מאסק צייר את זה:

ציור חביב, אבל החתול לא מגרד באוזן, האופנוע שלו איננו הארלי דיווידסון, ואין לנו מושג על מה הוא חושב. ועוד דוגמה - ככה GPT צייר את זה:

בנוסף לבעיות פיזיקליות (ראיתם איך הכוס מרחפת באויר?), מאד אהבתי איך GPT מנסה לייצג איך החתול חושב על פוליטיקה - בועת חשיבה מעל הראש של החתול, בתוך הבועה מאזניים, ועל המאזניים… מה בדיוק? שני גושים חסרי צורה. בנוסף, אל תפספסו את המעמד שנראה כאילו נועד לנאומים של פוליטיקאים, ועליו סימון עגול בצבעים אמריקאים של כחול-לבן-אדום, שיושב על הגלגל האחורי. שמעו - זה מאד מקורי אבל לא משכנע.

ועכשיו, דמיינו מה יקרה אם ניתן את התמונות הללו לפינוקיו ומספרים לו שכך נראית חשיבה על פוליטיקה… נראה לי ברור איז זה היה מתחיל להזיז את המחט לכיוונים הזויים , מה שרק היה מתעצם עוד יותר בהמשך, בדורות הבאים.

אז, זו הבעיה, הפטיש והסדן. לכל כיוון יש חסרונות. מה עושים כדי להתמודד עם הבעיה הזו? כותבי שני המאמרים מסבירים שאין ברירה, ויש רק דרך מוצא אחת שהם רואים מהברוך הזה: חייבים כל הזמן גם להזריק דאטה אנושי "מקורי" לדאטה שמאמנים איתו את פינוקיו, כדי לייצב את המודל החדש. באופן הזה אנחנו מקבלים דאטה מהקצוות שהוא אמין - נניח, תמונות של אנשים אמיתיים עם פרצופים אמיתיים שיש בהם צלקות אמיתיות, ולא רק מה שה-AI מדמיין שנראה כמו צלקת. הם מקדישים חלק מן המאמרים לדיון על כמות הדאטה הנדרשת מהסוג הזה, כלומר מה האיזון הנכון בין דאטה אנושי לסינתטי שיכול לשמר את השפיות של המודלים בין דור אחד לבא.

אוקיי. אז זהו "מבחן הזוויות", וזכיתם כאן לטעום קצת מהמאמרים העדכניים בתחום. ועכשיו, בואו ניקח כמה דקות כדי לעכל את כל זה, ולהבין מה כל זה בעצם אומר? לדברים שראינו עכשיו יש גם השלכות פרקטיות, וגם השלכות רעיוניות סביב השאלה של העונה שלנו. בואו נתחיל עם הפרקטיקה, ולאחריה נעבור להשלכות העמוקות יותר.

ההשלכה הפרקטית הראשונה של מה שראינו כאן היא המשך של מה שראינו בשבוע שעבר: שלעולם לא נוכל להפסיק להסתמך על בני אדם כדי לייצר לנו דאטה. בני אדם יצטרכו להמשיך לתייג תמונות וטקסטים ווידאו, וגם לייצר לנו תמונות, טקסטים וסרטים חדשים. הדברים כל כך ברורים שזה מוביל לכתבות קצת מצחיקות. כך לדוגמה נכתב באתר venturebeat שדיווח על הממצאים הללו: "בעתיד מלא בכלי AI גנרטיביים, תוכן שיוצר על ידי בני אדם יהיה יקר ערך עוד יותר מאשר היום — אם רק כמקור נתונים טהור לאימון AI.". שימו לב איך היוצרות מתהפכים: במקום שבני האדם ומה שטוב להם יהיה העיקר, הכותבים מדברים על כך שמבעד לעדשה של "בואו ניטיב עם המודלים שלנו" נצטרך לעודד אנשים להמשיך לייצר בעצמם תוכן, כדי שה-AI יהיה איכותי. די הזוי, לדעתי.

ההשלכה הפרקטית השניה, שקשורה לראשונה, גם היא עולה באותו מאמר, והיא הבעיה שיש עכשיו לכל מי שירצה לאמן מודלי AI חדשים על בסיס מה שיש באינטרט: שהרי, האינטרנט מתמלא כל הזמן בתוכן חדש, אבל אם בעבר כל התוכן הזה היה מיוצר על ידי בני אדם, ככל שיש יותר זמינות ל-GPT ודומיו, אז אחוזים ניכרים מהתוכן שיש באינטרנט נוצרים עכשיו על ידי מכונות, לא בני אדם. ממילא, הדאטה החדש שיאמנו עליו יהיו "פגום" בכך שהוא סינטטי מדי, והתופעה שעליה הזהירו כאן תתחיל לקרות: המודלים יתחילו לקרוס ולהיות לא רלוונטים. העולם עכשיו שואל את עצמו - איך נצליח להפריד בין דאטה מקורי-אנושי לבין דאטה "פייק"? הרי אנחנו חייבים את הדאטה האנושי הטהור כדי לאמן מודלים טובים! ולָעולם אין פתרון עדיין, שכן כל הקטע של המודלים הללו הוא שהם מצליחים לייצר פייקים אמינים בעיניים אנושיות… אז הבעיה הזו עדיין לא פתורה, ונראה בשנים הקרובות איך יתמודדו איתה.

אז אלו שתיים מהבעיות הפרקטיות המרכזיות, ועכשיו, לצד הרעיוני. וכאן יש המווון מה לומר, ואני אבחר ארבע עיקריות, בעיניי.

דבר ראשון, זה לחזור ולראות איך המאמרים הללו תומכים במה שאמרנו: המודלים אינם מייצגים את המציאות, אלא גרסה מפוקסלת ולא מדוייקת שלה. המציאות היא בעלת ריבוד אינסופי, ואפילו את מה שאנו יודעים היום אנחנו לא מצליחים לתפוס באף מודל באופן עמוק מספיק. המודל תמיד יהיה קירוב, ותו לא. וכמו אפקט הפרפר, שלפיו כנף פרפר שזזה היום יכולה לגרום לטורנדו בקצה השני של העולם בעוד כמה חודשים, הסטיות שיש בקירוב הזה מתעצמות בכל דור של אימון, אם לא נתקן אותן על ידי מידע אנושי אמיתי, אותנטי.

דבר שני, הוא התובנה ש"מבחן הזוויות" שלנו תופס עיוותים בתוצרי המודלים שמבחן טיורינג יכול הרבה פעמים לפספס. אז חשוב לשמור את הראש פתוח כשחושבים על מדדים לתבוניות. אולי צריך כמה מדדים ולא להסתפק בזה של טיורינג, עם כל זה שהוא מגניב ואינטואטיבי.

הדבר השלישי הוא מה שרמזתי אליו בתחילת הפרק: לשים לב שהבעיה שאנו רואים כאן היא בדיוק תולדה של הקונספט הכי שורשי של ה-AI בתקופה שלנו, שהכל זה עניין של מספיק דאטה. מה שמתברר לנו כאן בסיפור הזה הוא שאין בכך די. ברגע שהכל תלוי בכמויות הדאטה, אז הדברים הנדירים תמיד ימחקו מן התוצרים של המערכות הללו. דברים נדירים הם אולי נדירים, אבל הם חלק מהמציאות, וכשמתחילים למחוק חלקים מהמציאות כי אין לנו מספיק דאטה עליהם - הרי שהתוצר של המודלים מפסיק להיות שקול לזה האנושי. משהו צריך לעגן את המציאות שמופיעה באופן נדיר באותה עוצמה ויציבות של הדברים השכיחים, וזה דבר שאי אפשר לעשות ללא הבנה מראש של המציאות האמיתית, זו שמעבר לדאטה.

שווה להזכיר בשלב הזה שזה לא אומר שאין דרך לבנות מכשיר שיצליח במבחן טיורינג. אולי נזכיר כאן רק נקודה אחת למחשבה בעניין הזה: בני אדם לא עובדים כמו AI. הרי, ילדים מבינים מה זה חתול עם מספר דוגמאות קטן מאד. אף אחד מאיתנו לא ראה מיליוני תמונות של חתולים, אבל אנחנו עושים עבודה טובה יותר מה-AI בזיהוי שלהם רוב הזמן. כלומר, המוח האנושי עושה כאן משהו שונה ממה שהמערכות שבנינו עושות, אפילו אם הן משוכללות מאד. מה שזה אומר הוא שהמוח שלנו מכיל מערכות נוספות, משלימות לאלו שלומדות דברים מהדאטה הגולמי. ולכן, ההישענות היתירה על הדאטה היא מה שחושף את ה-AI לעקב האכילס שדיברנו עליו היום.

אז נראה, אם כן, שהפתרון לבעיות עולם ה-AI איננו באיסוף של דאטה נוסף, או לפחות לא בעיקר שם, אלא צריך משהו אחר: שינוי תשתיתי בגישה המחקרית של איך בונים AI, כדי להגיע למשהו חדש ועמיד בפני המגבלות הללו שחשפנו כאן בפרקים האחרונים.

והדבר הרביעי והאחרון להיום: לראות עד כמה “מבחן הזוויות” נשען על הרעיון של טיורינג, שאנחנו נחליט אם משהו הוא תבוני על פי התפוקה שלו. הרי יכול היה מישהו לבוא ולטעון - "טוב, כל מה שהצבעת עליו כאן בסיפור של ג’פטו ופינוקיו זו בעיה של דגימה. הפלט אולי חסר במשהו, אבל המוח של ה-AI, הדבר הזה שמסתתר בתוך הקופסה השחורה - הוא באמת חושב ותבוני! פשוט לא מצאנו את הדרך לגרום לו לדבר באופן שמשקף את המוח הזה כראוי". ובהחלט, אפשר להאמין שזה המצב, כל אחד לפי אמונתו. אבל כל הקטע של טיורינג היה לומר שלא מעניין אותנו איך נראה המנגנון הפנימי, כל עוד הוא מסוגל לייצר תפוקה כמו בני אדם. ולכן, כל עוד אי אפשר לייצר תפוקה ששקולה לזו האנושית, הרי שמבחן טיורינג בגרסת ה"זוויות" יוותר על כנו, ויחכה שמישהו ימצא דרך להוכיח שאכן הגענו למוח סינתטי אמיתי שם בפנים.

אז - זהו להיום! מהפרק הבא אנחנו נעמיק עוד יותר בשאלה של התבוניות של המערכות הללו, אבל עכשיו ממקום יותר עקרוני. כלומר, במקום להתמקד בצורה המיוחדת שבה הם מאומנים ומעוצבים, נשאל - האם יכולה בכלל להיות מכונה שכזו, שתחשוב כמו בני אדם? כפי שנראה, לאורך העשורים מאז שטיורינג הציע את ההצעה שלו, היו הרבה דיונים בנושא.

ובנוסף, עוד דבר שאנו ניאלץ להתמודד איתו ועד כה לא ממש עשינו: להסביר מה *באמת* קורה שם מתחת למכסה המנוע. כלומר, אם מה שיש שם הוא לא תבונה, אז… מה זה בדיוק? איך נכון לחשוב על התוכנה המתוחכמת הזו, באופן שגם יסביר את היכולות המטורפות שלה ובו זמנית יציב ליכולות הללו גבולות ברורים?

ועד אז - להתראות… .ביי…

Share this post